La ciencia enfrenta una crisis de credibilidad por la avalancha de 'AI slop'

Quienes confiamos en las noticias, internet o estudios científicos para entender temas de salud, medio ambiente o tecnología, solemos asumir que detrás de cada artículo académico hay años de trabajo, revisión y rigor. Sin embargo, en los últimos años, algo ha cambiado silenciosamente en la producción y circulación del conocimiento científico. Este cambio no solo afecta a investigadores o universidades, sino a cualquiera que dependa de la ciencia para tomar decisiones informadas.

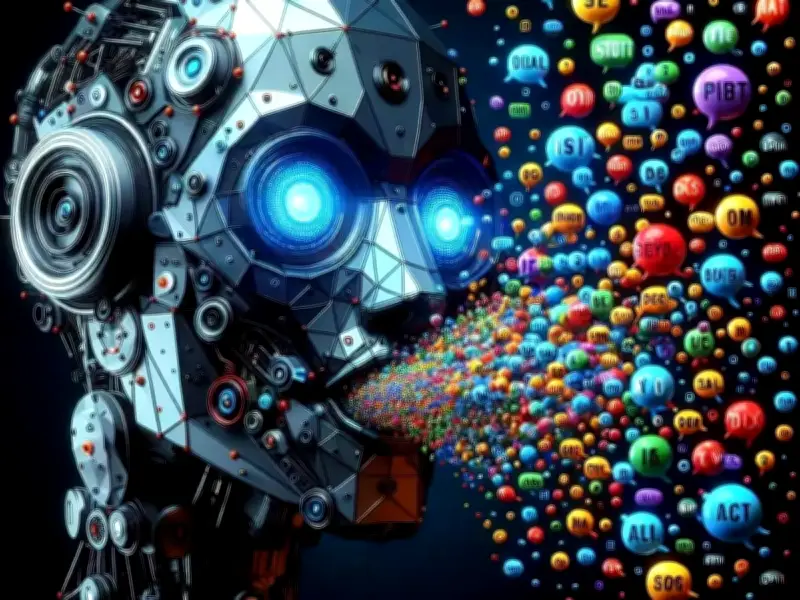

El fenómeno del 'AI slop': basura generada por inteligencia artificial

El periodista científico Ross Andersen, en un artículo para The Atlantic, utiliza la expresión contundente 'AI slop', que podría traducirse como 'basura generada por IA'. No se refiere únicamente a errores evidentes, sino a artículos que parecen científicos, usan lenguaje adecuado, estructura correcta y citas esperadas, pero en realidad no aportan conocimiento nuevo, contienen datos dudosos o incluso información completamente inventada.

Andersen inicia con un ejemplo revelador: Dan Quintana, profesor de psicología en la Universidad de Oslo, aceptó revisar un manuscrito para una revista académica. Al llegar a la sección de referencias, algo le llamó la atención: el texto citaba un estudio firmado por él mismo. El problema era que ese estudio nunca había existido. La cita era falsa, pero estaba redactada con tal precisión que solo alguien muy familiarizado con el tema podía detectarlo.

La multiplicación de casos y la saturación del sistema científico

Este tipo de errores no es anecdótico. Según Andersen, casos similares se han multiplicado desde la aparición de herramientas como ChatGPT y otros modelos de lenguaje capaces de producir textos largos, coherentes y con apariencia experta en cuestión de segundos. El resultado es una avalancha de artículos que saturan el sistema de publicación científica.

Durante décadas, los artículos científicos han sido 'los conductos a través de los cuales el conocimiento del mundo natural fluye hacia nuestra cultura'. Sin embargo, hoy esos conductos comienzan a obstruirse. Las revistas académicas, los congresos y los repositorios digitales reciben más trabajos de los que pueden revisar con cuidado, y muchos de ellos han sido total o parcialmente escritos por inteligencia artificial.

La IA no es un enemigo absoluto, pero su mal uso es alarmante

Es importante subrayar que Andersen no presenta a la IA como un enemigo absoluto. Reconoce que estas herramientas pueden ser útiles, por ejemplo, para investigadores cuya lengua materna no es el inglés y que necesitan apoyo para redactar con claridad. El problema surge cuando la IA no se usa como apoyo, sino como sustituto del pensamiento, la investigación y la verificación.

Editores y revisores —muchos de ellos académicos que realizan esta labor sin paga— enfrentan ahora un desafío adicional: distinguir entre trabajos legítimos y textos que solo simulan serlo. Mandy Hill, directora de publicaciones académicas de Cambridge University Press & Assessment, advierte que estos textos 'plausibles' son especialmente problemáticos, porque ya no fallan de manera evidente, sino que esconden errores profundos bajo una redacción impecable.

Ejemplos preocupantes y el riesgo en preprints

Andersen recopila varios ejemplos preocupantes:

- Artículos que incluyen citas a investigaciones inexistentes.

- Imágenes generadas por IA que pasaron procesos de revisión por pares antes de que alguien notara errores grotescos en su contenido.

- Estudios que analizaron miles de trabajos presentados en congresos científicos y encontraron patrones claros de generación automática: referencias falsas, párrafos repetitivos y ausencia de resultados verificables.

El problema se agrava en los llamados preprints, textos científicos que se publican en línea antes de ser revisados formalmente. Aunque estos repositorios son valiosos para acelerar el intercambio de ideas, la facilidad para subir documentos ha provocado que también se conviertan en canales de difusión de contenido de muy baja calidad, amplificado por motores de búsqueda y sistemas automáticos de recomendación.

Una llamada de atención urgente para la comunidad científica

La advertencia central del artículo es clara: si el sistema científico se llena de 'AI slop', la confianza en la ciencia puede deteriorarse. Investigadores, estudiantes, periodistas y ciudadanos tendrán cada vez más dificultades para distinguir qué estudios son sólidos y cuáles no. Peor aún, existe el riesgo de que, para hacer frente al problema, las editoriales recurran a más automatización, creando un círculo en el que la IA revise textos producidos por otras IAs.

Desde la perspectiva de quienes trabajamos con información, bibliotecas y publicaciones, este escenario resulta especialmente inquietante. La ciencia no solo depende de descubrir cosas nuevas, sino de comunicar con claridad, verificar con rigor y preservar la credibilidad del conocimiento.

El texto de Ross Andersen no es una condena definitiva a la inteligencia artificial, sino una llamada de atención. La pregunta no es si la IA debe usarse en la ciencia, sino cómo, con qué límites y bajo qué criterios de responsabilidad. Si no se responde pronto, la ciencia corre el riesgo de ahogarse no por falta de información, sino por un exceso de textos que parecen conocimiento, pero no lo son.

Basado en el artículo 'Science Is Drowning in AI Slop', de Ross Andersen (The Atlantic)

Mtro. Humberto Martínez Camacho – Bibliotecario Investigador de la Universidad Panamericana (UP)